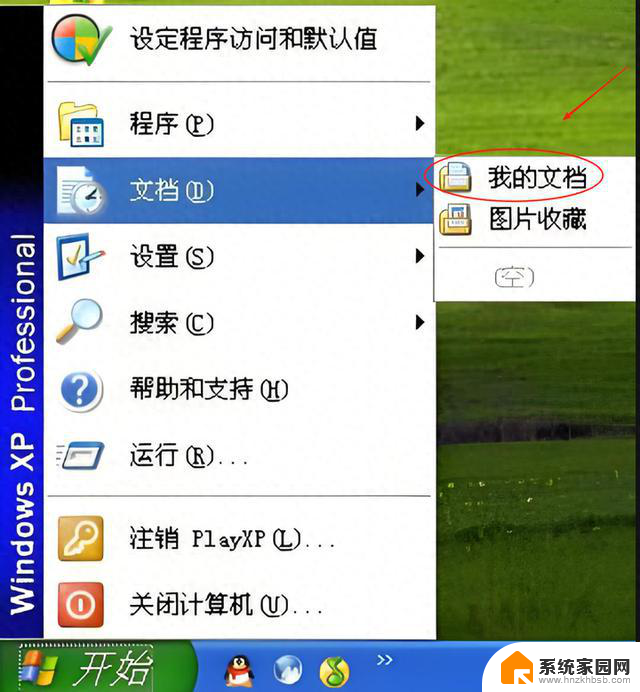

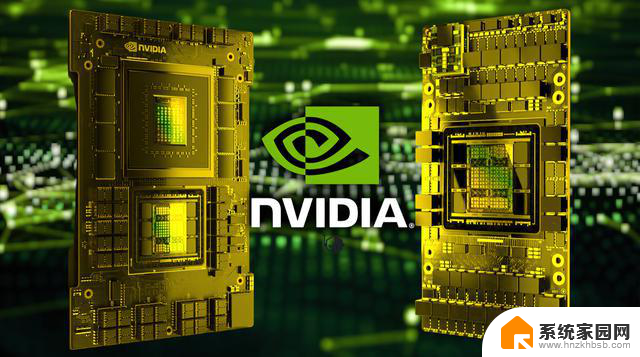

NVIDIA斥巨资为即将推出的Hopper H200和Blackwell B100订购HBM3E内存:最新内存技术助力显卡性能突破

韩国媒体称,英伟达已为 HBM3E 内存预付了约 7000 亿至 1 万亿韩元的费用,这一数字不一,但考虑到业界的巨大需求,我们预计实际金额将接近万亿韩元大关。仅预付款就约为 7.75 亿美元,实际数字可能超过 10 亿美元。这种大举砸钱的做法限制了其他公司的订货量,甚至使它们无法获得这些资源。

据业内人士 26 日透露,据了解,SK 海力士和美光分别从英伟达收到了 7000 亿到 1 万亿韩元的预付款,用于供应尖端内存产品。

NVIDIA 的大笔预付款导致了正在努力扩大 HBM 产能的内存半导体公司的投资行动。特别是最大的供应商 SK Hynix,据悉该公司正计划将从英伟达获得的预付款集中投资于扩大 TSV 设备,而 TSV 设备阻碍了 HBM 产能的提高。去年第三季度,建立新 TSV 生产线的相关工作顺利开展就是明证。同样,美光公司在 TSV 设施方面的投资也有望得到推动。

与此同时,据悉三星电子最近还与英伟达(NVIDIA)完成了 HBM3 和 HBM3E 产品适用性测试,并签署了供应合同。

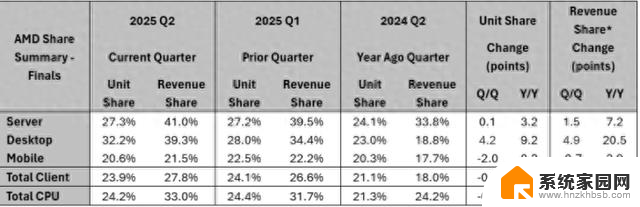

人工智能产业发展迅速,英特尔和 AMD 等公司都在加紧研发,以追赶英伟达在该领域的发展,因此绿队必须采取"先发制人"的措施,以保持其主导地位。

英伟达计划在下一代 Blackwell AI GPU 中首次采用 HBM3e,据传最终产品将于 2024 年第二季度推出,在性能方面,通过采用 chiplet 设计,它将在每瓦性能方面带来决定性的提升。此外,英伟达的Hopper H200 GPU还将配备世界上最快的HBM3E内存,因此该解决方案对于英伟达在人工智能和高性能计算市场取得成功意义重大。

英伟达(NVIDIA)对数据中心领域的创收抱有很大期望,因此他们显然要比别人领先一步。英伟达计划到 2027 年将人工智能驱动的销售收入提升到 3000 亿美元,因此确保向客户稳定供应人工智能 GPU 是他们的首要目标。另一个有趣的事实是,收购 HBM3E 将为 HBM 行业带来巨大的推动力,尤其是在扩建设施方面,因为订单积压一直是 SK hynix 和美光等公司面临的一个大问题,因此预先测量的供应意味着 HBM 的交付将变得更加容易。

NVIDIA目前处于主导地位,而且看起来还不会放弃自己的宝座,该公司在其 CUDA 平台上取得的进步以及其硬件部门已经彻底改变了市场现状,我们拭目以待未来的发展。