NVIDIA发布H200芯片:AI性能翻倍,国内专供版效能远超预期

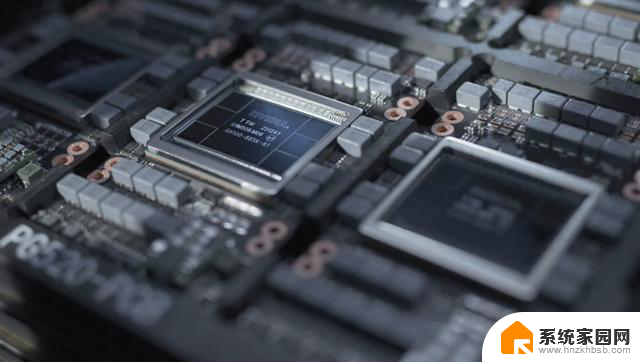

H200的架构依然是上一代的Hooper,但是在细节方面还是改进很多,主要是改进了Tensor Core,同时使用了最先进的显存,这主要是为了处理AI和高效能运算产生的大量资料。相比起NVIDIA上一代H100,H200在显存带宽上提高1.4倍、容量提高1.8倍,可以说以显存带宽和容量来提升处理密集型生成式AI工作的能力。

H200对显存的改变带来有意义的性能升级,H200首次采用HBM3e显存规格,使GPU的显存带宽从H100的每秒3.35TB 提高至4.8TB,显存总容量也从H100 的80GB 提高至141GB ,与H100相比,对Llama 2模型的推理运算速度几乎翻倍。NVIDIA自己表示:整合更快、更广泛的HBM显存有助于对运算要求较高的任务提升效能,包括生成式AI模型和高效能运算应用程式,同时优化GPU使用率和效率。

H200还能兼容目前H100的系统,NVIDIA 表示,云端服务商将H200新增到产品组合时不需要进行任何修改。首批H200预计2024年第二季出货,NVIDIA服务器制造伙伴(包括永擎、华硕、戴尔、Eviden、技嘉、HPE、鸿佰、联想、云达、美超微、纬创资通以及纬颖科技)可以使用H200更新现有系统。而亚马逊、Google、微软、甲骨文等将成为首批采用H200的云端服务商。

新的芯片推出肯定很昂贵,但NVIDIA 没有透露H200的价格,上一代H100价格估计为每个25000 美元至40000 美元,很显然H200单片价格肯定会超过40000美元。不过具体卖什么价格,NVIDIA表示这要由合作伙伴来决定。另外H200推出后,H100会继续销售,NVIDIA表示H100全年的供应量都在增加,显然整个市场对于H100的需求还是很大。

NVIDIA芯片被视为高效处理大量资料和训练大型语言模型、AI 生成工具最佳选择,在发表H200之际,大量AI公司仍在市场上拼命寻求H100。所以对于H200这个新的芯片来说,大家的疑问是能不能够顺利买到,还是说会和H100一样供不应求?但无论如何,在可见的未来中,大家都会选择NVIDIA的芯片来训练AI,NVIDIA在AI领域的优势依然难以动摇。

有意思的是,国内显然是买不到H200的,甚至连H100和A100的阉割品都无法买到。NVIDIA基本已经确定会向中国市场出口HGX H20、L20PCle 和L2PCle这三款定制版的AI芯片,HGX H20 和L20 系列已正式向中国客户提供芯片样品,相较前代产品运算能力有所降低,不过H20 GPU 拥有96GB HBM3显存,显存带宽为4.0TB/s,而这甚至比H100带宽更高。所以NVIDIA打算规避算力方面的麻烦,而用提升显存带宽来增强在AI方面的性能,这样可以规避美国的出口管制,同时对中国客户也有交代。

当然从实际算力来看,据悉即使是特供给国内的最高端芯片H20,实际算力也不足H100的1/4,和H200相比恐怕差距已经难以计算了。不过好处是之前采用NVIDIA芯片的国内厂商,买来直接就能用,价格便宜点则可以多买一些,这样勉强能达到自己的需求。至于国内部分的AI芯片,华为以及其他厂商都受限于工艺制程,实际上很难和NVIDIA竞争。当然对于国内厂商来说,先解决有无和适用的问题,再去考虑芯片的性能更科学。